Education*

Devops

Architecture

F/B End

B.Chain

Basic

Others

CLOSE

Search For:

Search

BY TAGS

linux

HTTP

golang

flutter

java

fintech

개발환경

kubernetes

network

Docker

devops

database

tutorial

cli

분산시스템

www

블록체인

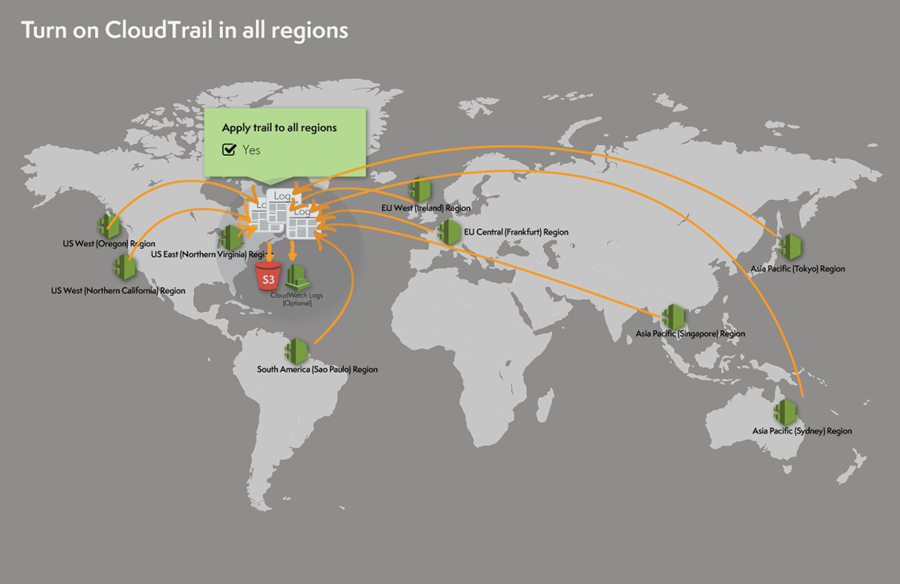

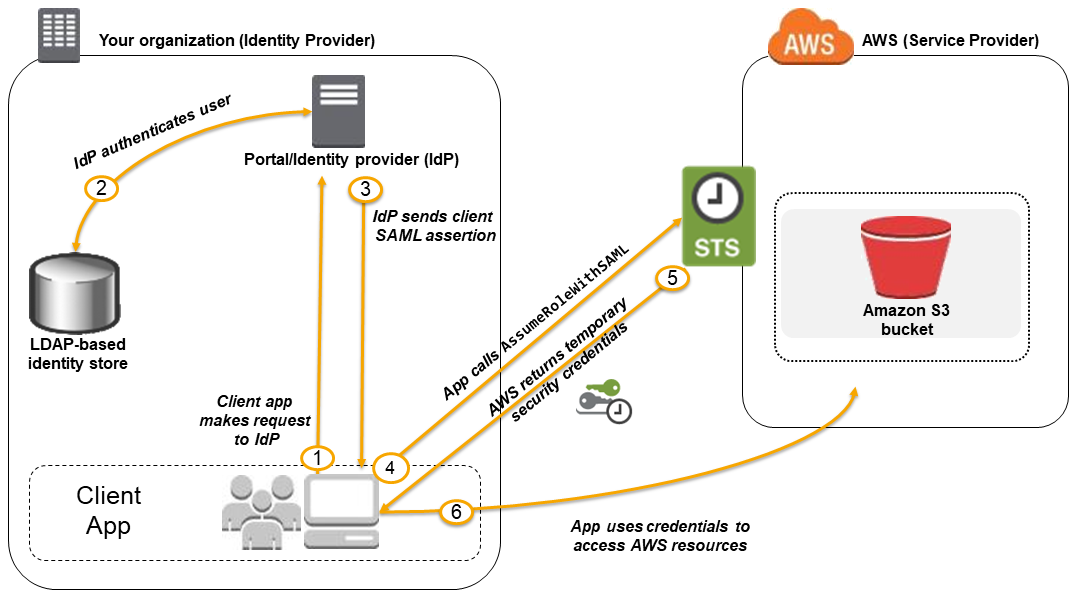

AWS

system admin

bigdata

보안

금융

msa

mysql

redis

Linux command

dns

javascript

CICD

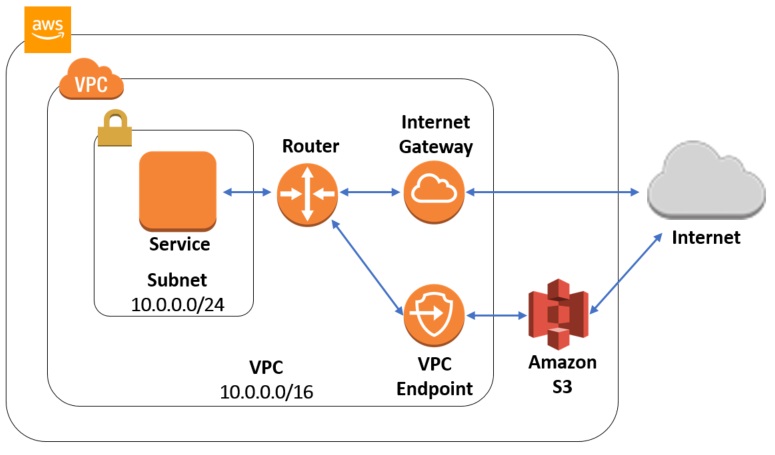

VPC

FILESYSTEM

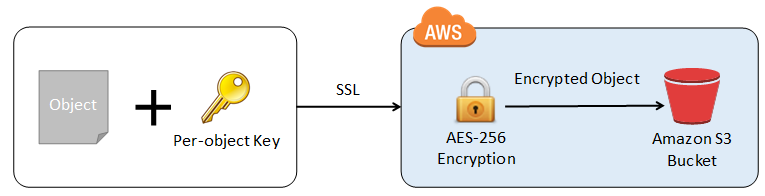

S3

NGINX

TCP/IP

ZOOKEEPER

NOSQL

IAC

CLOUD

TERRAFORM

logging

IT용어

Kafka

docker-compose

Dart

AWS 솔류션 아키텍트 어소시에이트 등급 문제 풀이

Recommanded

Free

YOUTUBE Lecture:

<% selectedImage[1] %>

yundream

2022-08-13

2021-02-24

6761